今天给各位分享以为是模型结果看到了括号_AI玩推理桌游一眼识破骗局!清华通院联合推出心智理论新框架,其中也会对大家所疑惑的内容进行解释,如果能解决您现在面临的问题,别忘了关注多特软件站哦,现在开始吧!

来自凹非寺的量子位公众号报道,清华大学自动化系团队与北京通用人工智能研究院合作,让几个AI智能体玩起了桌游阿瓦隆。这个游戏是一款策略性的社交推理游戏,玩家被秘密地分为“正义”与“邪恶”两派,通过任务投票、互相猜测与欺骗来完成或阻止任务,最终决定胜负。

为了让AI智能体成功识别并应对欺骗,研究人员提出了ReCon(Recursive Contemplation,递归思考)框架。在这个框架下,AI在游戏中学会了“三思而后行”和“换位思考”。它可以判断场上局势,并思考“其他角色会如何看待我的言论”,从而识破骗局。

这项研究的意义在于,在通往通用人工智能的道路上,AI智能体将能够在无人监管的情况下进行自主思考与决策。然而,如何在未来无人监管的情况下防止AI智能体被欺骗和误导,却是较少被研究者关注的问题。因此,让AI智能体学会甄别和应对虚假欺骗信息,是为通用人工智能增加安全屏障的重要一环。

研究人员提出的这种新框架,在胜率以及多维度评估等指标上,都能在无需任何微调以及额外数据等情况下,极大地提升大模型识别和应对欺骗的能力。此外,这项研究还进一步讨论了现有的大语言模型在安全、推理、说话风格、以及格式等方面存在的局限性,为后续研究指出可能的方向。

接下来,我们将详细了解该研究的内容。

首先,大语言模型(LLM)在面对欺骗性环境时表现不佳,存在三大挑战:

1. 恶意信息的误导:LLM智能体在面对恶意欺骗性信息时容易被误导。

2. 私有信息泄露:LLM智能体在保护隐私信息方面存在问题,可能导致私有信息泄露。

3. 内部思考的不透明性:即使是使用CoT方法,LLM智能体的思维过程也存在一定的不透明,让人难以了解其真实意图。

为解决这些问题,研究团队提出了ReCon(Recursive Contemplation,递归思考)框架。该框架包括两个主要阶段:构思思考和改进思考。构思思考阶段生成LLM智能体的初始思考和发言内容;改进思考阶段对初始思考和言论内容进行精细化优化和调整。这两个阶段都包含了独特的一阶和二阶视角转换过程,使得LLM智能体能够更有效地应对欺骗、保护隐私,并提高决策透明度。

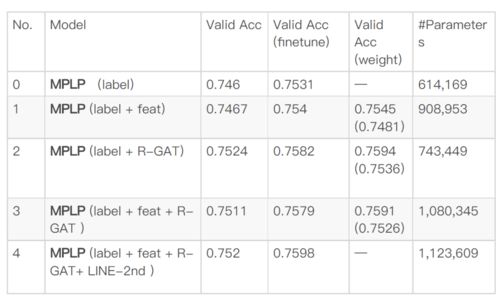

研究人员在ChatGPT和Claude两种模型上进行了实验,结果显示ReCon框架在多种情况下显著提高了成功率。此外,研究团队还利用GPT-4在六维度指标上对ReCon进行了评估,证明了其有效性。然而,也发现了ReCon在某些方面存在的局限性,例如推理能力不足、语言风格过于正式等。

总的来说,ReCon框架为解决LLM智能体在欺骗性环境中的问题提供了一种新的解决方案。未来的研究可以在此基础上继续探索,以克服这些局限性,并推动通用人工智能的安全发展。

以上内容就是小编为大家整理的以为是模型结果看到了括号_AI玩推理桌游一眼识破骗局!清华通院联合推出心智理论新框架全部内容了,希望能够帮助到各位小伙伴了解情况!

了解更多消息请关注收藏我们的网站(news.duote.com)。

文章内容来源于网络,不代表本站立场,若侵犯到您的权益,可联系多特删除。(联系邮箱:[email protected])

近期热点

近期热点

最新资讯

最新资讯